发布日期:2025-08-16 08:07 点击次数:70

最近啊,我盯了苹果的技术圈两天,憋不住了。

这次不是新品发布,也不是什么冷门配件。

是大伙都关心的AI提速黑科技。

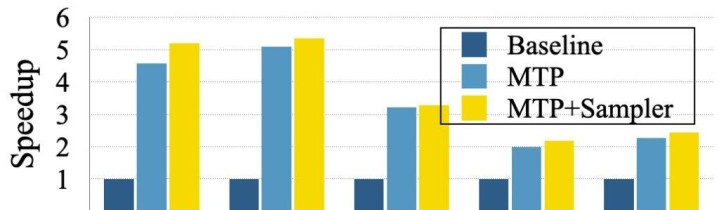

苹果研究团队,居然把大模型在iPhone上的运行速度,直接干到最快提升5倍。

我说真的,5倍啥概念?以前用Siri磨磨唧唧半天,好家伙,按现在这思路,可能你还没眨眼,它就能把答案蹦出来。

我自己当晚就找了资料,还追了9to5Mac的原帖,确认不是标题党。

先聊技术,别着急走。

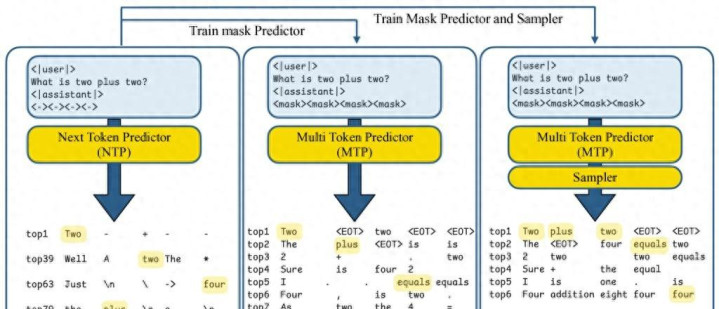

其实这次的核心技术叫“MTP”,全名是“多token预测”。

咋解释呢。

传统AI模型,尤其是现在火的LLM,都是一口一个词,一个Token往外蹦。

每写一个词,都得根据前面内容推一遍,好家伙,磨人的很。

你让它写“The cat is black”,它就‘The’,‘cat’,‘is’,‘black’,一点点憋出来。

但苹果这回脑洞开得大。

他们发现,模型内部其实能一次同时猜后面好几个词。

有点像打麻将摸一手好牌,还知道别人下步要出啥。

所以他们直接上了掩码Token,模型一次能预测好几个词,一下子速度爆表。

最高据说一次能推8个Token。

实际测下来正常场景下提速两三倍,代码、数学那种本来慢得要死的,能快到5倍。

我看了下实验,他们用的是Tulu3-8B这个开源模型,不是苹果自家闭源那一套。

所以兼容性,放心,挺有戏。

尤其是,这流程不是粗暴加速。

他们搞了个“推测-验证”机制。

模型猛猜一串词,系统会立刻对照标准结果。

不合适立刻回退,一步步来。

速度提起来了,质量没掉队。

说白了,苹果这回技术,不是拿云端吹牛皮,是奔着手机本地实用去的。

你不需要信号特别强,只要有iPhone、Mac这种设备,纯本地推理。

延迟低,能耗降。

其实我自己一直担心啥?

以前大模型都限制手机本地跑,只能用云算力。

理论上强,实际卡成狗。

但苹果这项目,直接把MTP技术和“门控LoRA适配”结合。

只有需要高速时激活,平时该慢慢推就慢慢推。

这样能保证不乱费资源。

我说句实话,这种方案,应该算是目前所有大厂最像“真机可用”的一套。

再看价格。

别拿AI芯片硬件价去套,这次是纯软件加速。

只要你的iPhone能更新到今年的新系统,等苹果下半年推Apple Intelligence,极大概率会内置。

白嫖落地,无需额外花钱。

这个“程度”,真是第一次看到AI大模型硬件党在软件上低头。

以往你没设备性能,AI体验少一半。

这回,苹果直接拍桌:“你管设备啥性能,我直接给你提速方案。”

二手iPhone党,也能爽爽用AI。

就跟刷个系统,比花新钱买高性能机还划算。

我查了下闲鱼,最近苹果高端机价格没涨,但这类软提速,肯定会激发一波老机升级潮。

都盯着系统更新的动态,抢先体验。

话说,这技术也不是全无隐患。

哪些场景提速到5倍?这部分官方没说死。

而且升级了,缓存和能耗会不会爆炸?

还有有朋友问,这和ChatGPT那套有什么关系?

说白了,就是苹果自己的大模型,和外部API没多大关联。

你用Siri也好,用Apple Intelligence也好,底层是本地授权算力。

云端交互多半会被自己家的加速方案“降维打击”一下。

如果你问我这段技术里有什么坑?

第一,别过于期待低端设备能上满速,最极限其实还是看硬件。

第二,有强制本地推理的需求,有些功能跑不过云,也别死磕。

第三,这东西落地,厂商一定玩一波营销,老机升级有没有“偷工减料”最好等实测。

最后,说说我的劝。

这类技术,刚需党闭眼升级没毛病。

等官方推送,直接吃螃蟹。

非刚需,或者用得少的,建议先看看大伙反馈,有Bug别玩太猛。

就像当年M1芯片刚出时,我硬着头皮去折腾,体验是爽,但那种“不成熟的bug”才是真的醉了。

总的来说。

提速5倍,不用买新设备,AI体验倒挂“云端”,这种事,苹果能干出来我真的没想到。

这波属于无脑收藏,等着开箱测评吧。

别忘了提前升级。

#苹果 #AI提速 #本地大模型 #捡垃圾心得 #Siri #技哥说